九游APP:如何选择适合的存储介质进行信息管理

作为该系列的开篇文章,本期如何选择适合的存储介质进行信息管理我们将从宏观的角度带你观察大数据行业的整体生态结构,对大数据采集、数据的分布式存储与处理,以及在此基础之上的数据分析、可视化和在众多行业中的应用进行概述。其后的每篇文章我们都会挑选大约5个行业的数十家典型公司进行详细介绍,并会对其中一个重点行业进行逻辑的梳理与详细案例的剖析。那么首先我们就来说说大数据技术是如何产生的如何选择适合的存储介质进行信息管理?

关注大数据观察网(微信公众号:shuju_net)如何选择适合的存储介质进行信息管理了解更多精彩资讯

第一 大数据的技术基础

早在1980年,著名未来学家托夫勒在其所著的九游下载《第三次浪潮》中就热情地将“大数据”称颂为 “第三次浪潮的华彩乐章”,这标志着人们首次对海量数据所能够产生的价值有了初步的了解。

但由于连接方式的局限,长期以来人们对于数据的应用大多以企业内部的商业智能为主,随着互联网、移动互联网的普及,企业终于能够直接与用户产生链接并获得大量的用户行为与消费等数据,大数据产业应用的轮廓才渐渐清晰。

2000年初Google为了实现对大量网页的信息抓取、存储,并完成索引的建立及排序功能,同时又希望降低硬件采购成本而逐渐摸索出了利用普通物理机实现的分布式存储、计算体系。这一技术以MapReduce及GFS而为人所熟知,借此大数据得以分布存储在多个数据库中,并进行大规模并发处理,解决了以往单一计算机存储能力不够,计算时间过长而不具备实用性的问题。

依据2003年底Google所发布的论文,前雅虎工程师开发出了类似的分布式存储计算技术Hadoop,随后围绕Hadoop产生了庞大的生态体系,逐渐使大数据基础架构日臻完善。

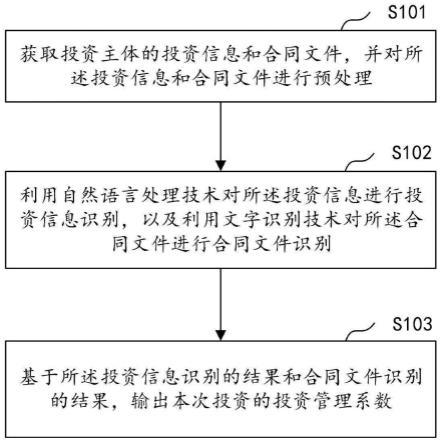

Hadoop功能包括从数据采集、存储、分析、转运、再到页面展示,完整涵盖了整个流程。例如HDFS实现了数据的分布式存储,HBase负责实现数据库的功能,Flume执行对数据的收集,Sqoop能够对数据进行转移、治理, MapReduce可以通过算法实现分布式计算,Hive则做数据仓库,Pig做数据流处理,Zookeeper实现了各节点间的反馈收集与负载平衡服务,Ambari能够让管理员了解架构整体的工作运行情况。

Hadoop生态技术架构

而随着技术的发展九游官网,一些适应独特应用场景的数据库、计算处理等软件也越发丰富,例如非结构化数据库MongoDB就因为其较为强大的条件查询功能以及灵活的数据结构获得了广泛的应用;Spark则将Hadoop中的存储介质替换为闪存,而获得了百倍处理速度的增长,Databricks Cloud就是这一架构下的产品化服务。

除此之外大数据生态中还存在着很多的技术发展路径,其中MPP技术主要还是以关系型数据库为主和Hadoop技术目标类似,都为了将数据切分、独立计算后再汇总。相对于SQL on Hadoop,MPP具有数据优化程度高、计算速度快,擅长被用于进行交叉分析等优点,适合企业进行数据分析使用,但其扩展性相对Hadoop来说较弱,一般在10个节点以上便丧失了计算优势,并且由于非开源架构导致其对特定硬件依赖程度较高。

采用MPP存储模式的代表性公司有Teradata,能够通过进行企业数据分析帮助员工减轻大数据处理的精力消耗与费用成本,使企业能够更加专注于业务运营。在传统数据库公司与意图进入数据库市场的企业服务公司(例如SAP)掀起的收购热潮中,Teradata是目前市场仅存的几家大型独立数据分析公司之一。

第二 大数据的数据来源

2011年麦肯锡发布了一份题为“Big Data: The Next Frontier for Innovation, Competition and Productivity”的报告,里面提到美国拥有1000人以上规模的公司平均存储了超过200T的数据,如果对数据进行价值挖掘将激发很多行业及公司的潜力,这一报告标志了商业领域大数据热潮的开端,也使企业服务软件成为了大数据最初的数据源。

随着存储及计算能力的加强和国内大数据产业的兴起,部分从业者在看到行业巨大前景的同时也意识到了国内数据资源的缺乏,由于民生、电信、交通、电力等具有很高价值的数据都掌握在政府及大型国企中并不开放,如何获取数据源成为了比如何提升数据处理方法更大的问题。

目前国内能够进行脱敏并使用的市场数据的来源主要还是集中在手机、PC等单一渠道与场景中,TalkingData、友盟,以及艾瑞、易观等数据分析及咨询机构很大程度上依赖着这些资源,却也被这些资源所局限。而由于政府数据的敏感性,仅有少数机构能够对接政府数据资源。因此预计随着对数据需求的日益强烈以及数据资源价值被渐渐接受,政府数据资源将会成为数据源的重要组成部分。

而更大范围的数据采集工作将会依托于物联网领域。我们在《即将被281亿个传感器包围,你却还没弄懂物联网技术如何选择适合的存储介质进行信息管理?》中曾讲到,预计2020年我们将会被281亿个传感器包围,本月27号中国联通也宣布截至目前其物联网联通数量已超过5000万个。可以预见的是,在消费者视角内,未来衣食住行等方方面面都将会配备物联网设备实时采集数据,而采集来的数据将会让商家提供更优质、甚至是定制化的服务,形成双赢。而在工业领域,物联网所采集的大数据也将发挥很大的作用,形成良性循环。

同样随着数据样本与采集渠道的丰富,针对数据采集过程、数据转换与传送和数据存储环节的服务也已经有了很大的发展,Informatica及Mulesoft就是多渠道数据的集成与数据治理行业中的代表性企业。

第三 大数据的分析及可视化

在有了足够的存储与计算能力,并获得了大量的数据后,数据分析产业的发展水到渠成。目前通用性的数据分析行业,主要有数据分析、数据分析可视化、大数据检索,以及延伸出的数据服务平台、商业智能分析及大数据预测与咨询这6大类业务。

数据分析的内容将会在第二及第三篇文章中详细介绍,今天仅介绍一下数据分析的整体情况,及未来可能的发展方向。

大数据分析的出现,对企业而言最大的价值就是能够将大量沉淀的用户行为数据、消费数据、企业服务软件中的数据进行整合,并通过对这些数据的分析来优化产品设计、价格的制定和销售方法的提升,同时降低企业内部运转的成本提高运营效率,例如Pentho通过抓取企业服务软件(主要为SAP)中的各类数据并挖掘及分析,最终能够帮助企业节约大量的报表制作时间,并让管理者能够实时看到企业的运行情况。

同样对于电信、电力以及交通等专业领域的企业来说,通过收集用户数据,可以分析并预测未来的需求,提前对价格进行实时智能调节,并合理分配负载,从而实现利润的最大化并保证运行的安全。

而对舆情数据的分析能够帮助企业及时了解市场情绪,并快速迭代自己的产品与服务,对于金融企业来说也可以快速获知最新动态避免因为信息不对称而暴露于风险中。例如Datameer提供的数据分析引擎就能够实时监测公共消息,检测其语言和传播方式,使用户能够早于媒体报道获得最新资讯,并通过可视化的方式使用户轻松快速上手。

大数据可视化,则是建立在大数据分析之上的,让人们能够更加便捷的理解数据分析结果的手段。大多数提供数据可视化业务的公司都将其作为对数据分析的延伸业务,例如Bottlenose 在进行数据分析自动化业务的同时,提供对社交媒体分析的“声纳图”,能够让用户对复杂的关系及逻辑线条一目了然,提升了用户对其数据分析业务的采纳程度。

预计随着数据分析手段与方法的不断升级,数据的可视化工作将成为重点方向,将日益复杂化的数据分析结果与人相连接将会面临技术不断的挑战。

第四 大数据的行业应用

大数据技术已经被视为了未来经济生活中的基础设施,这意味着几乎全部行业都能够在大数据分析技术之上获得经济效率的提升。星河研究院此次将大数据应用的研究范围覆盖到了20多个行业,包含电子商务、媒体营销、物流、企业服务、教育、汽车、金融科技等诸多产业,这一部分行业与公司的介绍将会放在第四到第七篇文章中。

在销售行业中,通过输入客户的性格、穿搭习惯、所处行业及历史销售数据等信息,销售员将会被大数据分析告知,何时给哪一位客户打电话获得订单的概率最高;在品牌形象建立中,Persado能够依据市场情绪的分析,写出与用户能够产生共鸣的文案从而获取消费者好感;法律行业中Ravel能够“阅读”过去数十万判决案例,针对用户输入的案件给出判决概率预测,帮助律师制定辩护策略,而长期来看法律大数据企业很有可能取代大部分初级律师;同样在零售、广告、医疗等诸多领域,大数据技术都能通过分析数据内在的关系而帮助用户实现购买预测、受众精准投放以及病情辅助判断等功能。大数据的行业应用精彩纷呈,远不止上文所提到的这些,接下来的文章中我们会逐一展现大数据应用的神奇。

第五 大数据成为AI产业的燃料

人工智能技术一直是科学家与技术人员的追求,但其发展并不是一帆风顺。例如最初的自然语言识别技术中,科学家希望通过语法规则使计算机理解语义从而实现智能化,但显示证明这一路径并不可行,其后依据大量数据样本的统计方法才有效的提升了自然语言处理的准确度并逐渐达到可用水平。

如今随着计算技术与数据量的提升,大数据能够带给我们的福利已经不仅限于资料的查找,识别语言、视觉的AI技术提供给我们的,除了经常看到的“个人助理”和动态美颜等功能外,仿照大脑结构进行写作、自动记录会议纪要、情绪识别与性格分析,甚至是视频内容的搜索等功能都能够对商业及产业起到较大的推动作用。

鸣谢:王刚

注:

Hadoop, 由Apache基金会所开发的分布式系统基础架构

HDFS是Hadoop中的分布式文件系统,适合运行在通用硬件设备上九游APP,具备高度容错性,能提供高吞吐量的数据访问,非常适合大规模数据集上的应用。

MapReduce是一种编程模型,用于大规模数据集(大于1TB)的并行运算,极大地方便了编程人员在不会分布式并行编程的情况下,将自己的程序运行在分布式系统上。

MPP,Massively Parallel Processing,意为大规模并行处理系统,这样的系统是由许多松耦合处理单元组成的,每个单元内的CPU都有自己私有的资源,在每个单元内都有操作系统和管理数据库的实例复本。

SAP是全球最大的企业管理和协同化商务解决方案供应商、全球第三大独立软件供应商,总部位于德国。

GFS是Google开发的可扩展分布式文件系统,用于大型的、分布式的、对大量数据进行访问的应用,能够运行于普通硬件上,并提供容错功能。